A pesar de los impresionantes avances que la inteligencia artificial ha demostrado en los últimos años, superando incluso las capacidades humanas en tareas complejas como el análisis de grandes conjuntos de datos y el reconocimiento de patrones estáticos, existe un ámbito donde la sutileza y la intuición humana se mantienen como referentes insuperables: la comprensión de las interacciones sociales dinámicas.

Mientras la IA ha logrado decodificar imágenes fijas con una precisión asombrosa y procesar el lenguaje natural con una fluidez creciente, la capacidad de "leer entre líneas" en situaciones sociales sigue siendo un desafío formidable para los algoritmos más avanzados.

Una reciente investigación, liderada por científicos de la Universidad Johns Hopkins, ha arrojado luz sobre esta persistente brecha, evidenciando que los modelos de inteligencia artificial actuales aún no pueden igualar la destreza humana para interpretar y predecir cómo interactúan las personas en el mundo real.

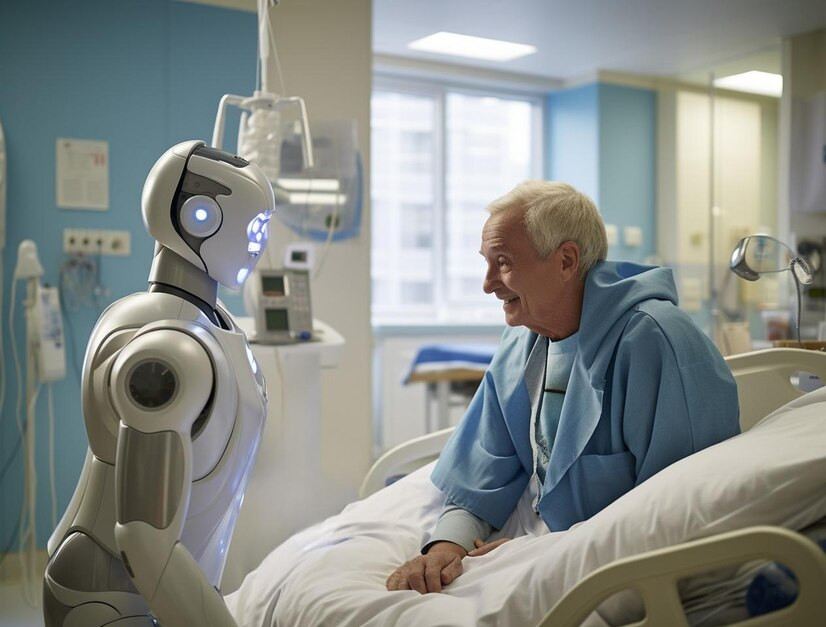

Este hallazgo subraya que la habilidad de comprender las dinámicas sociales en tiempo real, esencial para el desarrollo de tecnologías como los coches autónomos y los robots de asistencia que deben coexistir y colaborar con los humanos, continúa siendo un dominio eminentemente humano, al menos en el estado actual de la tecnología.

Para poder comparar de manera objetiva la capacidad de la inteligencia artificial con la percepción humana en este aspecto crucial, los investigadores de Johns Hopkins diseñaron un experimento meticuloso. En este estudio, se solicitó a un grupo de participantes humanos que observaran una serie de videoclips de tan solo tres segundos de duración.

El contenido de estos breves videos mostraba diversas situaciones sociales, incluyendo personas interactuando directamente entre sí, individuos realizando actividades en proximidad pero sin interacción explícita, y personas actuando de manera completamente independiente. Tras la visualización de cada clip, los participantes humanos debían calificar en una escala del uno al cinco diferentes aspectos que se consideran fundamentales para la comprensión de las interacciones sociales, como el nivel de comunicación, la intencionalidad de las acciones y el contexto general de la escena.

Una vez recopiladas las evaluaciones humanas, los investigadores se dispusieron a confrontarlas con las predicciones realizadas por un amplio abanico de más de 350 modelos de inteligencia artificial. Este conjunto de modelos incluía diversas arquitecturas y enfoques, abarcando modelos de lenguaje, modelos de video y modelos de imagen, lo que permitió una comparación exhaustiva de las diferentes capacidades de la IA en este dominio.

A estos modelos de IA se les pidió que predijeran cómo los humanos habían juzgado los videos y, en algunos casos, cómo respondería el cerebro humano al observar las mismas escenas. En particular, a los modelos de lenguaje de gran escala se les proporcionaron subtítulos concisos, creados por humanos, para que pudieran evaluar las dinámicas sociales descritas en ellos.

Los resultados de este exhaustivo estudio revelaron un contraste significativo con el ya conocido éxito de la inteligencia artificial en la interpretación de imágenes estáticas. Mientras que los participantes humanos demostraron un notable nivel de acuerdo entre sus evaluaciones de las interacciones sociales en los videoclips, los modelos de IA, sin importar su sofisticación o la cantidad de datos con los que habían sido entrenados, fueron incapaces de replicar esta consistencia en sus predicciones.

En concreto, los modelos de vídeo mostraron una clara dificultad para describir con precisión las acciones que estaban teniendo lugar en las escenas. Incluso cuando se proporcionó a los modelos de imagen una secuencia de fotogramas estáticos extraídos de los videos, estos fueron incapaces de determinar de manera fiable si las personas que aparecían en ellos estaban comunicándose entre sí.

Es importante destacar que los modelos de lenguaje exhibieron una mayor capacidad para predecir el comportamiento humano en comparación con los modelos de video e imagen. Por otro lado, los modelos de video demostraron ser más efectivos a la hora de predecir la actividad neuronal que se registraba en el cerebro humano al observar los mismos videos. Sin embargo, la conclusión general del estudio fue que ninguno de los modelos de IA logró igualar la precisión y la comprensión holística que los participantes humanos mostraron al analizar las interacciones sociales presentadas.

La razón fundamental detrás de esta disparidad en la capacidad de comprensión radica en la forma en que el cerebro humano y las redes neuronales de la IA procesan la información visual dinámica.

Los investigadores postulan que las redes neuronales artificiales actuales se inspiraron principalmente en la arquitectura de la parte del cerebro humano que se encarga del procesamiento de imágenes estáticas. Esta área es distinta de la región cerebral que se activa y procesa las escenas sociales dinámicas, que implican movimiento, intenciones y relaciones cambiantes entre los individuos.

La realidad, a diferencia de una fotografía, es inherentemente dinámica. Para poder interactuar de manera efectiva en el mundo real, la inteligencia artificial necesita desarrollar la capacidad de comprender la narrativa que se despliega en una escena, incluyendo las complejas relaciones interpersonales, el contexto situacional y las sutiles dinámicas que gobiernan las interacciones sociales.

Los humanos, a través de la evolución y la experiencia, han desarrollado una comprensión intuitiva y compartida de estas dinámicas. Esta inteligencia social humana se nutre de una vida de experiencias encarnadas, de la memoria emocional acumulada, de la interpretación de señales no verbales y de la internalización de un vasto contexto cultural, elementos que actualmente escapan a la comprensión de los modelos de IA, por muy avanzados que sean.

La demostrada incapacidad de la inteligencia artificial para comprender las sutilezas de las dinámicas sociales humanas tiene implicaciones significativas para el desarrollo futuro de la IA, especialmente en aquellos campos donde la interacción con personas es un componente esencial. Un ejemplo paradigmático es el del coche autónomo, que para operar de manera segura y eficiente en entornos reales, necesita ser capaz de anticipar las intenciones y acciones de los conductores y peatones que lo rodean.

La investigación sugiere que actualmente existe un "punto ciego" en el desarrollo de los modelos de IA en lo que respecta a esta crucial capacidad de interpretar el comportamiento social. Superar esta limitación será fundamental para el avance de la llamada "IA encarnada", que incluye robots diseñados para asistir a personas mayores o para el cuidado infantil, tareas que requieren una comprensión profunda de las necesidades emocionales y sociales de los humanos.

Estas observaciones también invitan a una reflexión sobre cómo se diseñan y utilizan las interfaces entre humanos y máquinas. Existe la necesidad de explorar nuevos enfoques en el desarrollo de interacciones más naturales y efectivas.

En lugar de simplemente aumentar la escala de los modelos existentes, podría ser necesario enseñar a la IA a ver el mundo como una historia y no como diapositivas, lo que implica dotarla de la capacidad de comprender la secuencia temporal de los eventos y el contexto en el que se desarrollan las interacciones. En este sentido, la colaboración entre humanos y la inteligencia artificial podría ser una estrategia prometedora, combinando la potencia de procesamiento de datos de la IA con la inteligencia social y emocional intrínseca de los seres humanos.

A pesar de los notables progresos de la inteligencia artificial en otros dominios, los humanos todavía mantienen una clara ventaja en la interpretación de las interacciones sociales dinámicas y en la comprensión del complejo entramado del contexto social. Así que la habilidad de descifrar las intrincadas sutilezas que subyacen a las interacciones sociales sigue siendo, por el momento, una capacidad distintivamente humana.